Met de A100 presenteert Nvidia de eerste GPU met Ampere-architectuur. De enorme 7nm-chip is naar verluidt niet alleen aanzienlijk krachtiger, maar ook veel flexibeler dan zijn voorganger Volta. Met DGX A100, HGX A100 en EGX A100 zijn er platforms voor datacenters en edge computing.

Het eponiem voor Nvida’s Ampère-architectuur is de Franse natuurkundige en wiskundige André-Marie Ampère, naar wie de eenheid van ampère Ampère is vernoemd. De naam past, want Nvidia’s Ampere processor A100 is veruit de krachtigste GPU ooit gemaakt. In sommige toepassingen zou het tot 20 keer sneller zijn dan zijn voorganger Volta, aldus Jensen Huang, oprichter en CEO van Nvidia.

Op de grens van 7 nm-technologie

In tegenstelling tot zijn voorganger V100 met Volta-architectuur, wordt de A100 bij TSMC niet langer in 12 nm, maar in 7 nm gefabriceerd. Met een oppervlakte van 826 mm² is de Ampere-chip toch groter. Het aantal transistors is ten opzichte van de V100 toegenomen van 21,1 miljard tot 54 miljard. Daarmee zit de chip op de grens van wat haalbaar is met 7 nm, aldus Huang.

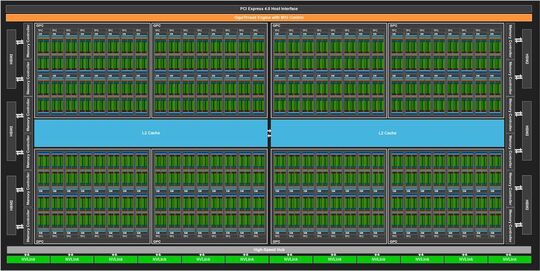

De A100, als eerste implementatie van de GA100 hardware-architectuur met in principe tot 128 streaming multiprocessors(SM), heeft 108 actieve SM’s. Deze zijn onderverdeeld in 3.456 FP64-kernen en 6.912 FP32-kernen. Hoewel het aantal FP64- en FP32-kernen aanzienlijk is toegenomen ten opzichte van de GV100, heeft Nvidia het aantal tensorkernen teruggebracht van 640 tot 432. Deze Tensor Cores van de derde generatie zouden echter aanzienlijk krachtiger zijn, vooral voor AI-toepassingen, omdat ze overweg kunnen met Tensor Float 32 (TF32), een nieuw floating-point formaat dat het gegevensbereik van FP32 combineert met de nauwkeurigheid van FP16. Vergeleken met Volta zou Ampere dus een factor 20 sneller zijn in AI-training met lage nauwkeurigheid. Sparcity is een relatief nieuwe benadering van het optimaliseren van diepe neurale netwerken. Met de GA100-architectuur introduceert Nvidia Structural Sparsity Acceleration: nieuwe Sparse Tensor Core-instructies die de doorvoer van sparse matrixbewerkingen verdubbelen met TF32-, FP16-, BFLOAT16-, INT8- en INT4-formaten. Bovendien moeten de werklasten beter worden verdeeld over de afzonderlijke nodes.

Daarnaast versnellen de Tensor Cores FP64 voor HPC-toepassingen. Zo presteert een A100 volgens Nvidia 19,5 TFOPS tegenover 7,8 TFLOPS voor de V100-chip.

De Level 2 cache van de A100 is 40 MB, 6,7 keer groter dan die van de V100 en verdeeld in twee partities om de bandbreedte te vergroten en de latency te verkleinen.

Met op het GPU-pakket 40 GB snel HBM2-geheugen in de vorm van vijf stacks met acht geheugendiesels per stack. Nvidia claimt een geheugenbandbreedte van 1.555 GB/s, 1,7 keer hoger dan Volta. De SXM4-module met de A100 GPU ondersteunt nu PCI Express 4.0, en NVLink 3.0 wordt gebruikt om meerdere A-100 chips te communiceren, twee keer zo snel als NVLink 2.0 met 600 GB/s.

API-ondersteuning voor Ampere’s innovaties is opgenomen in Cuda 11. Daarnaast biedt Nvidia GPU-geoptimaliseerde containers voor deep learning, machine learning en HPC-toepassingen die al de Cuda 11-toolkit bevatten. Zij zijn slechts een onderdeel van de volledige softwarestack, die ook vooraf getrainde modellen omvat.

Tot zeven GPU’s in één

Om systemen met A100 GPU’s flexibeler te maken, maakt de nieuwe Multi-Instance GPU (MIG)-functie het mogelijk om elke GPU op te splitsen in maximaal zeven afzonderlijke GPU-instances, elk ontworpen om de prestaties van een V100 te leveren voor specifieke toepassingen. Elke instantie heeft zijn eigen paden in het volledige geheugensysteem. Met MIG kunnen individuele VM’s of containers de instances geïsoleerd en met gedefinieerde QoS gebruiken. Dit is vooral belangrijk voor dienstverleners. In een DGX-A100-systeem of een OEM-systeem met acht GPU’s elk, kan MIG ook selectief worden geactiveerd op afzonderlijke GPU’s.

Amp-systemen voor het datacenter

Nvidia biedt de A100 GPU voor datacentergebruik niet aan als insteekkaart, maar alleen als compleet DGX-A100 systeem of als boards uitgerust met meerdere GPU’s voor OEM-fabrikanten. De DGX A100 is al de derde DGX-generatie van Nvidia. Volgens de fabrikant is het systeem de eerste 5-petaFLOPS server ter wereld. Nvidia CEO Huang legt uit dat een datacenter met vijf DGX-A100 systemen voor AI training en inferentie ongeveer dezelfde prestaties levert als een eerder datacenter met 50 DGX-1 systemen voor training en extra servers met ongeveer 600 CPU’s voor de overige taken. De vijf DGX-A100-servers hebben 28 KW nodig en kosten ongeveer een miljoen US dollar, terwijl het vorige datacenter meer dan 11 miljoen kostte met een stroomverbruik van 630 KW. Voor extreme eisen biedt Nvidia een DGX SuperPOD met 140 DGX-A100 systemen en 700 PetaFLOPS. De afzonderlijke systemen zijn met elkaar verbonden door netwerkcomponenten van Mellanox. Nvidia heeft onlangs Mellanox overgenomen.

In een enkel DGX-A100-systeem in een 4U-vormfactor zitten acht A100 GPU’s die onderling verbonden zijn door zes NVSwitches via NVLink 3.0. Ze zitten op een moederbord met twee huidige AMD Epyc 7742-processoren van de Rome-generatie met elk 64 kernen. Intel, de processorleverancier voor de vorige DGX-systemen, heeft nog geen processoren met PCI Express 4.0 ondersteuning in zijn portfolio. Dit komt pas met Ice Lake SP later dit jaar.

Het hoofdgeheugen op het moederbord is één TB, de massaopslag bestaat uit PCIe 4.0 SSD’s met een totale capaciteit van 15 TB. De netwerkconnectiviteit wordt geleverd door acht Mellanox single-poort ConnectX-6 VPI voor 200Gb/s HDR Infiniband en één dual-poort ConnectX-6 VPI voor 200Gb/s Ethernet.

Voor cloudproviders die hun eigen servers laten assembleren of voor OEM-fabrikanten biedt Nvidia twee verschillende HGX-A100 baseboards. De grote variant is uitgerust met acht GPU’s en ontworpen voor systemen met twee CPU’s, de kleine variant met vier is bedoeld voor single-CPU-systemen. De verbinding met de moederborden met CPU’s en RAM wordt telkens tot stand gebracht via PCI Express.

Volgens Nvidia moeten systemen met HGX A100 afkomstig zijn van de fabrikanten Atos, Cray, Dell, Fujitsu, Gigabyte, HPE, Inspur, Lenovo, QCT en Supermicro. Nvidia noemt Alibaba, AWS, Baidu, Google, Microsoft Azure, Oracle en Tencent als cloudproviders met A100-systemen.

Amping edge computing

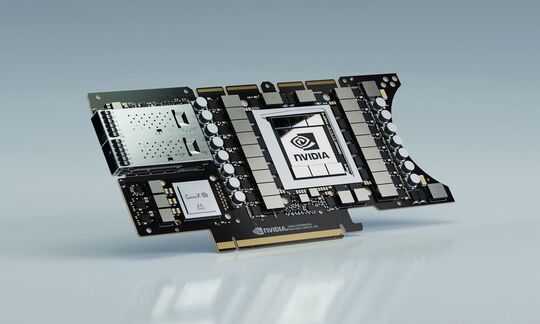

Voor toepassingen aan de netwerkrand komt Nvidia met de EGX A100 PCIe-insteekkaart met een A100 GPU en een Mellanox ConnectX-6 DX voor 100Gb/s Ethernet of Infiniband. Nvidia noemt smart citiy, geneeskunde, 5G-infrastructuur, spraakherkenning, robotica en autonoom rijden als toepassingsgebieden. Nvidia biedt toepassingskaders voor al deze sectoren. Terwijl de DGX-A100 systemen reeds bij klanten zijn, zouden de EGX-A100 kaarten tegen het eind van het jaar beschikbaar moeten zijn.