De eisen voor opslag en gegevensbeheer veranderen met de toepassingen. Hybride cloud-ondersteuning is nu gemeengoed, samen met opslagoplossingen voor containers en Kubernetes. Opslagsystemen voor AI-workloads zijn een groeiende business.

Het is inmiddels een waarheid als een koe dat de gegevensvoorraad van bedrijven en instellingen snel blijft groeien als gevolg van de toenemende digitalisering. In de industrie genereren moderne productieprocessen met hun ontelbare sensoren en meetpunten enorme hoeveelheden gegevens die moeten worden opgeslagen en geanalyseerd. Ook in de administratie, de gezondheidszorg, de detailhandel en de dienstensector neemt de behoefte aan opslag toe. Het gaat er niet alleen om de gegevens op te slaan, maar ze moeten voortdurend toegankelijk zijn om ze te kunnen analyseren en te gelde te maken.

Hoewel een aanzienlijk deel van de gegevensstroom de datacentra van de cloudproviders binnenstroomt, bestaan er bij veel bedrijven en nog meer in de overheidssector bedenkingen tegen de public cloud. Eén reden is bezorgdheid over beveiliging en naleving, een andere is dat de kosten hoger zijn dan verwacht, vooral wanneer grote hoeveelheden gegevens moeten worden opgevraagd. Bovendien zijn er veel toepassingen, vooral in edge computing, die zeer snelle toegang vereisen, wat de publieke cloud niet kan garanderen. De meeste bedrijven geven daarom de voorkeur aan hybride cloudoplossingen, die vrijwel alle opslagleveranciers in hun portfolio’s hebben.

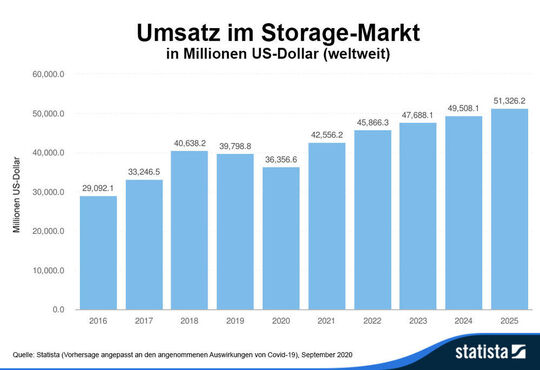

De afgelopen jaren is de markt voor externe opslagsystemen gestaag gegroeid om gelijke tred te houden met de toenemende hoeveelheid gegevens. Hoewel volgens de marktonderzoekers van IDC een flink deel van de stijging te danken is aan de ODM-fabrikanten, bij wie de grote hyperscalers als AWS, Microsoft Azure en Google inkopen, doen de voor het kanaal relevante leveranciers ook nog steeds goede zaken. De belangrijkste inkomstengeneratoren zijn all-flash systemen, terwijl hybride flash arrays terrein verliezen. Pure externe opslagoplossingen komen verder onder druk te staan door hyperconvergente systemen, waarvan de verkoop de afgelopen jaren met dubbele cijfers is gegroeid.

Databeheer is in trek

Met de hybride cloud neemt de behoefte aan efficiënt databeheer toe, zodat gegevens snel van on premises naar een of meer cloudproviders en weer terug kunnen worden verplaatst. Hier hebben niet alleen de opslagfabrikanten zelf, maar ook een aantal fabrikanten van derden geschikte oplossingen in de aanbieding. Met het groeiende belang van microservices, containers en orkestratiesystemen zoals Kubernetes, brengen opslagfabrikanten geschikte oplossingen op de markt om hun opslagsystemen bruikbaar te maken vanuit Kubernetes en te verbinden met clouddiensten. In het algemeen zijn softwaregedefinieerde opslagtoepassingen in opkomst.

Twee andere groeifactoren voor de opslagsector zijn Big Data en AI. Hoewel cloud-opslag hier in aanzienlijke mate wordt gebruikt, gebruiken veel gebruikers lokale opslag, althans gedeeltelijk, om redenen van prestaties of gegevensbescherming. Voor AI-projecten, zoals machine- en deep learning, wordt een grote verscheidenheid aan opslagsystemen gebruikt, aangezien hier aan verschillende eisen moet worden voldaan. Naast cloud-opslag zijn dat onder meer object-opslag en gedistribueerde bestandssystemen, waarmee een grote hoeveelheid gegevens zodanig kan worden opgeslagen dat er sprake is van continuïteit. Voor het trainen van de modellen zijn snelle full-flash opslagsystemen in trek, bij voorkeur uitgerust met NVMe SSD’s.

Flash is booming, HDD en tape blijven actueel

All-flash systemen staan op de tweede plaats op de lijst van opslagproducten en -oplossingen die systeemhuizen belangrijk vinden in ons panelonderzoek, net achter cloudopslag. Op technologisch gebied zijn er momenteel verschillende ontwikkelingen die zorgen voor betere prestaties enerzijds en lagere prijzen anderzijds. NVMe brengt meer snelheid, en in de toekomst nog meer met PCI Express 4.0, NVMe-oF en Storage Class Memory (SCM). Met SCM wordt een extra laag tussen het hoofdgeheugen en flash ingevoegd, waardoor de toegang in opslagsystemen wordt versneld, NVMe-oF minimaliseert de latentie in systemen die via Fibre Channel (FC), Infiniband of snel Ethernet zijn verbonden.

Kosteffectievere all-flash-systemen met tegelijkertijd een hogere capaciteit worden mogelijk gemaakt door het gebruik van QLC-flash. Hier mag, volgens de fabrikanten, de duurzaamheid niet te lijden hebben onder aangepaste software. Met de Zoned Namespaces (ZNS), een onlangs goedgekeurde uitbreiding van de NVMe-standaard, wordt een toegangsmodel gedefinieerd dat is gebaseerd op dat voor SMR HDD’s. De SSD is verdeeld in zones waarvan de toewijzing met gegevens rechtstreeks wordt gecontroleerd door de toepassingen. De voordelen zijn minder overprovisioning en goedkopere SSD’s, omdat er minder DRAM nodig is als cache.

De HDD blijft belangrijk als goedkoop opslagmedium, ook al daalt de verkoop van pure HDD en hybride opslagsystemen. Momenteel hebben fabrikanten 3,5 inch HDD’s met 20 TB opslagruimte bereikt. In de toekomst wordt verwacht dat technologieën zoals MAMR (Microwave Assisted Magnetic Recording) of HAMR (Heat Assisted Magnetic Recording) de capaciteit verder zullen opvoeren tot meer dan 30 TB.

Tape-technologie blijft de laatste verdedigingslinie tegen gegevensverlies. Als offline systeem is het de beste bescherming tegen ransomware-aanvallen en soortgelijke cyberaanvallen. Andere argumenten ten gunste van tape zijn de lage energiekosten en de lange houdbaarheid van het opslagmedium. Zelfs de grote hyperscalers vertrouwen daarom allemaal op tape als onderdeel van hun backup-strategie. Met de regeling van het octrooigeschil tussen Fujifilm en Sony zijn LTO-8 tapes met een opslagcapaciteit van 12 TB nu weer verkrijgbaar. De LTO-9 norm, waaraan onlangs de laatste hand is gelegd, zou 18 TB ongecomprimeerd en 48 TB gecomprimeerd moeten kunnen opslaan. Het gebruik van stronium in plaats van bariumferriet moet binnen enkele jaren zelfs tapes met een capaciteit van 400 TB mogelijk maken.

AI-toepassingen hebben grote hoeveelheden gegevens nodig om goed te kunnen functioneren. Kurt Gerecke onthult de juiste opslagstrategie in een interview.

Mr. Gerecke, wat ziet u als de grootste uitdagingen waar gebruikers en bedrijven momenteel voor staan op het gebied van opslag en data-analyse? En aan welke eisen moeten opslagsystemen voldoen voor AI-workloads?

Kurt Gerecke: De beste manier om de toekomstige eisen voor opslaginfrastructuren uit te leggen, is door te kijken naar AI-projecten zoals machine- en deep learning, omdat dergelijke projecten een grote verscheidenheid aan eisen vereisen. Een van de belangrijkste elementen ligt op het gebied van schaalbaarheid, gegevensbeheer en prestaties. De uitdaging vloeit voort uit de fase van de gegevensverzameling, de verwerking van de gegevens en de opleiding van de neurale netwerken. Hier zijn de meest uiteenlopende infrastructuren vereist.

Zo kunnen cloud-opslagoplossingen, objectopslag, online-archieven en bestandssystemen een belangrijke rol spelen in de verzamelingsfase van de gegevens uit de meest uiteenlopende bronnen. Ook schaalbaarheid speelt hier een belangrijke rol. Voldoende bandbreedte, willekeurige IO’s voor lezen en schrijven en intelligente verplaatsing van gegevens naar de juiste opslaglocaties zijn vereist voor het categoriseren en voorbereiden van de gegevens. Voor de opleidingsfase zelf zijn meestal een hoge verwerkingscapaciteit (random read), de snelste reactietijden, lineaire schaalvergroting, workflowintegratie, verschillende versies en verschillende varianten vereist. Zodra het algoritme klaar en bruikbaar is, is het met het oog op de naleving van de voorschriften van belang dat de traceerbaarheid van de gegevens die voor de opleiding zijn gebruikt, wordt gewaarborgd, d.w.z. dat deze gegevens audit-proof worden gearchiveerd.

Voor deze archivering zal het medium tape zeer zeker een belangrijke rol spelen. De datapijplijn vanaf het verzamelen van de gegevens tot de training en daarna weerspiegelt dus de meest uiteenlopende eisen, en om hier volledig aan te voldoen ligt de uitdaging voor opslaginfrastructuren zoals we die in de toekomst nodig zullen hebben.

IT-BUSINESS is mede-organisator en mediapartner van de DATA Storage & Analytics Technology Conference 2020. Als u de heer Gerecke en vele andere interessante sprekers live wilt meemaken, schrijf u dan in! De conferentie vindt plaats onder inachtneming van een gedetailleerd uitgewerkt hygiëneconcept van de Vogel IT-Akademie.

► Naar de agenda & registratie – DATA Storage & Analytics Conference 2020

.mybutton { background-color:#4aa829; display:inline-block; cursor:pointer; color:#ffff; font-size:15px; padding:13px 31px; width:65%; } .mybutton:hover { background-color:#545454; } .mybutton:active { position:relative; top:1px; }

+++ Ihre Sicherheit liegt uns am Herzen +++

Selbstverständlich hat die Gesundheit der Veranstaltungsteilnehmer, Aussteller und aller Mitarbeiter höchste Priorität. Aus diesem Grund hat die Vogel IT-Akademie die notwendigen Sicherheitsvorkehrungen zusammen mit den Veranstaltungslocations erhöht und ein Hygienekonzept ausgearbeitet.